文章详情页

python - celery 如何解决worker和client代码同步问题

浏览:199日期:2022-08-31 11:17:47

问题描述

我的celery worker在A机器, client在B机器, 这样每次代码更新我都必须同时更新A和B,并且依次停掉client, celery worker, 再依次开启celery worker和client, 这样不就非常麻烦吗? 有什么好的解决方案?

问题解答

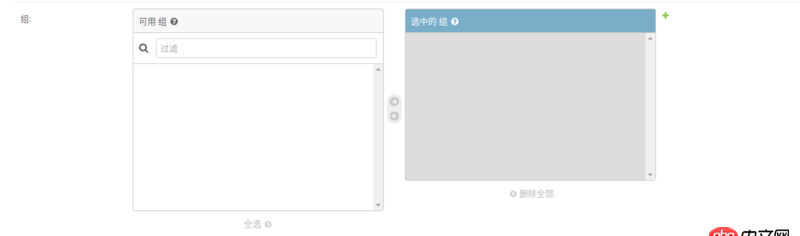

回答1:第一,celery更新了代码是必须要重启的,因为脚本都已经加载到内存,你要更新只能重启了。

第二,同步代码的办法,那就有很多了,比如:rsync或者其它的部署系统fabric,Ansible等等都可以达到你的要求。

处理逻辑都是你这样的,只不过可以做成自动化。

相关文章:

1. mysql sum去除重复2. 老师无限级分类有点难哟 不好理解3. javascript - swiper.js嵌套了swiper 初始设置不能向下一个滑动 结束后重新初始4. 为什么span的color非要内联样式才起作用?5. 提示内部服务错误什么问题6. python - Django ManyToManyField 字段数据在 admin后台 显示不正确,这是怎么回事?7. 请问没有对以太网通信进行封装的python库?8. python - pysciter 如何配置运行环境?9. python - 如何修改twisted自带的日志输出格式?10. php由5.3升级到5.6后,登录网站,返回的是php代码,不是登录界面,各位大神有知道的吗?

排行榜

网公网安备

网公网安备