文章详情页

python - scrapy运行爬虫一打开就关闭了没有爬取到数据是什么原因

浏览:123日期:2022-08-05 15:09:38

问题描述

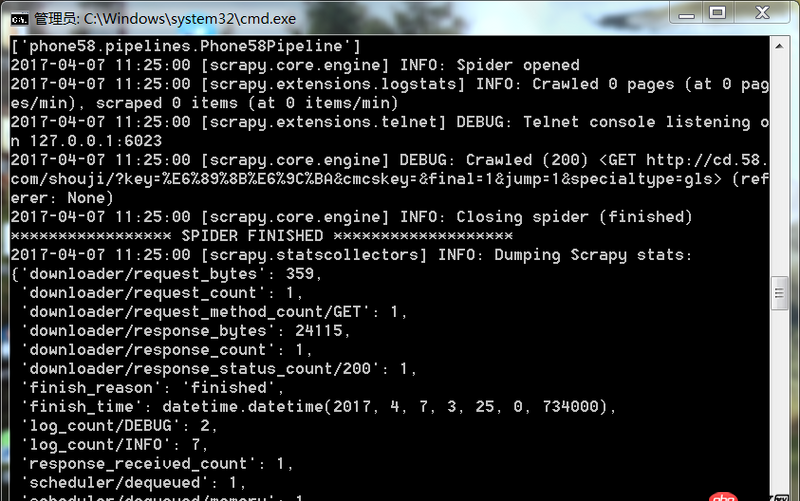

爬虫运行遇到如此问题要怎么解决

问题解答

回答1:很可能是你的爬取规则出错,也就是说你的spider代码里面的xpath(或者其他解析工具)的规则错误。导致没爬取到。你可以把网址print出来,看看是不是[]

相关文章:

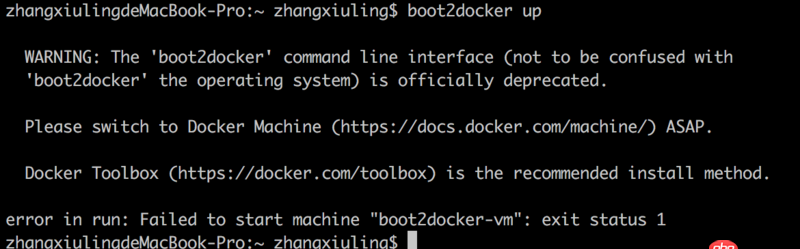

1. boot2docker无法启动2. node.js - antdesign怎么集合react-redux对input控件进行初始化赋值3. 关于docker下的nginx压力测试4. 新建文本后面没有txt 重命名后也没有变化5. pdo_mysql 值自增写法6. mysql多表联合查询优化的问题7. mysql亿级数据的标签数据库如何正确建索引进行模糊查询8. mysql - 对同一个表同时更新2条记录,但更新不同字段,会不会造成数据丢失?9. 数据库 - Mysql的存储过程真的是个坑!求助下面的存储过程哪里错啦,实在是找不到哪里的问题了。10. php+mysql 根据ID 循环下载数据 每次下一笔

排行榜

网公网安备

网公网安备