文章详情页

python - 在编写scrapy爬虫的时候rules中allow的书写问题

浏览:171日期:2022-08-01 16:58:44

问题描述

在编写爬取58同城二手手机出售的信息的时候,rules里的allow应该怎么写?它里面给出的下一页或者第二页第三页等等的链接给出的都是缩减的链接,那么rules里的allow应该要怎么写呢?有哪位高手可以指点一二嘛?谢谢~

问题解答

回答1:缩减的链接可以用urljoin()组合啊

相关文章:

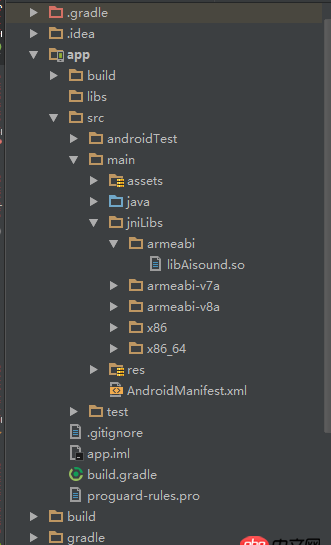

1. java - mybatis源码分析2. 修改mysql配置文件的默认字符集重启后依然不生效3. Android-studio导入.so库问题?4. docker容器呢SSH为什么连不通呢?5. 在windows下安装docker Toolbox 启动Docker Quickstart Terminal 失败!6. docker内创建jenkins访问另一个容器下的服务器问题7. css - html根字体设置成很大的值后, 包裹了行内元素的div莫名变高是什么原因8. 请教一个python字符串处理的问题?9. docker api 开发的端口怎么获取?10. docker网络端口映射,没有方便点的操作方法么?

排行榜

网公网安备

网公网安备