python - scrapy爬虫不能循环运行?

问题描述

scrapy只能爬取一个页面上的链接,不能持续运行爬完全站,以下是代码,初学求指导。

class DbbookSpider(scrapy.Spider): name = 'imufe' allowed_domains = [’http://www.imufe.edu.cn/’] start_urls=(’http://www.imufe.edu.cn/main/dtxw/201704/t20170414_127035.html’) def parse(self, response):item = DoubanbookItem()selector = scrapy.Selector(response)print(selector)books = selector.xpath(’//a/@href’).extract()link=[]for each in books: each=urljoin(response.url,each) link.append(each)for each in link: item[’link’] = each yield itemi = random.randint(0,len(link)-1)nextPage = link[i]yield scrapy.http.Request(nextPage,callback=self.parse)

问题解答

回答1:是不是爬得太快让封了

相关文章:

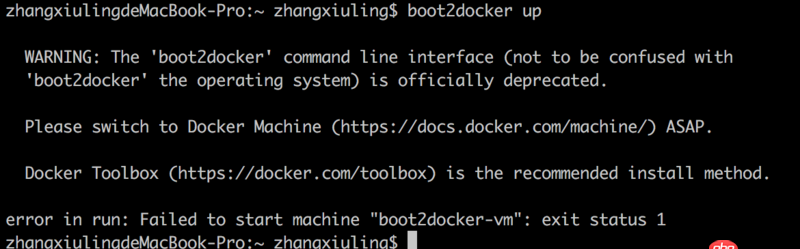

1. thinkphp6使用验证器 信息如何输出到前端页面2. boot2docker无法启动3. Android-Studio 新建项目 Missing styles4. php为什么是源程序显示?5. javascript - 我这个页面的main的盒模型为什么把header的模型空间也包括了。6. 老师,flex-shrink: 1; 按视频操作,不会自动缩放7. mac里的docker如何命令行开启呢?8. golang - 用IDE看docker源码时的小问题9. docker容器呢SSH为什么连不通呢?10. debian - docker依赖的aufs-tools源码哪里可以找到啊?

网公网安备

网公网安备