网页爬虫 - python的多进程怎么配合requests

问题描述

这是单进程顺序执行的代码:

import requests,time,os,randomdef img_down(url): with open('{}'.format(str(random.random())+os.path.basename(url)),'wb') as fob:fob.write(requests.get(url).content)urllist=[]with open('urllist.txt','r+') as u: for a in u.readlines():urllist.append(a.strip())s=time.clock()for i in range(len(urllist)): img_down(urllist[i])e=time.clock()print ('time: %d' % (e-s))

这是多进程的代码:

from multiprocessing import Poolimport requests,os,time,randomdef img_down(url): with open('{}'.format(str(random.random())+os.path.basename(url)),'wb') as fob:fob.write(requests.get(url).content)if __name__=='__main__': urllist=[] with open('urllist.txt','r+') as urlfob:for s in urlfob.readlines(): urllist.append(s.strip()) s=time.clock() p=Pool() for i in range(len(urllist)):p.apply_async(img_down,args=(urllist[i],)) p.close() p.join() e=time.clock()print ('time: {}'.format(e-s))

但是单进程和多进程花费的时间几乎没区别,问题大概是requests阻塞IO,请问理解的对不对,代码该怎么修改达到多进程的目的?谢谢!

问题解答

回答1:写文件的瓶颈在磁盘IO,并不在CPU,你并行并没有多大作用,你可以试试不要写入文件再对比时间

回答2:Pool 不带参数的话 是采用 os.cpu_count() or 1如果是单核CPU,或者采集不到数量 就只有1个进程而已。

应该是这个原因。

相关文章:

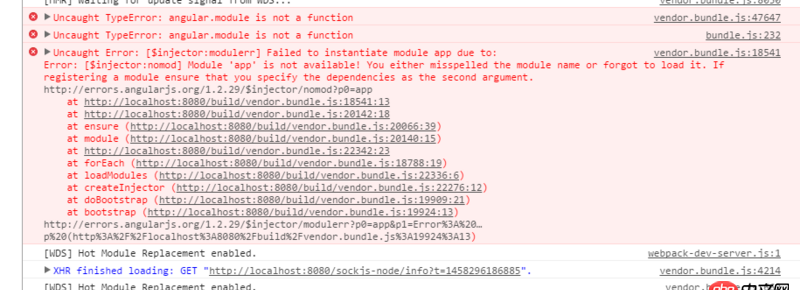

1. 为什么span的color非要内联样式才起作用?2. angular.js - angular-ui-bootstrap 报错无法使用?3. javascript - swiper.js嵌套了swiper 初始设置不能向下一个滑动 结束后重新初始4. python - Django ManyToManyField 字段数据在 admin后台 显示不正确,这是怎么回事?5. python - 如何修改twisted自带的日志输出格式?6. docker - 如何修改运行中容器的配置7. 求救一下,用新版的phpstudy,数据库过段时间会消失是什么情况?8. 请问一下各位老鸟 我一直在学习独孤九贱 现在是在tp5 今天发现 这个系列视频没有实战9. 在cmd下进入mysql数据库,可以输入中文,但是查看表信息,不显示中文,是怎么回事,怎新手,请老师10. 如何使用git对word文档进行版本控制?

网公网安备

网公网安备